Internetuhr

3FS 和smallpond:DeepSeek开源周第五天

3FS https://github.com/deepseek-ai/3FS 3FS(Fire-Flyer F […]

DualPipe、eplb、profile-data:DeepSeek开源周第四天

DualPipe https://github.com/deepseek-ai/DualPipe DualPi […]

DeepGEMM:DeepSeek开源周第三天

DeepGEMM是什么? DeepGEMM是一个高效通用矩阵乘法(GEMM)库,专为FP8(8位浮点数)精度设 […]

DeepEP:DeepSeek开源周第二天,又一个榨干GPU的库

DeepEP是什么? DeepEP 是由 DeepSeek 开发的一个开源通信库,专门为混合专家模型(Mixt […]

FlashMLA:DeepSeek开源周的第一天

今天是DeepSeek开源周的第一天,它开源了FlashMLA。 FlashMLA是什么? FlashMLA […]

Veo 2实测:演员要失业了

这两天,Google的Veo 2悄悄地出来了。今天,我简单地测试了一下。 怎么样?有没有点偶像剧的感觉。可惜, […]

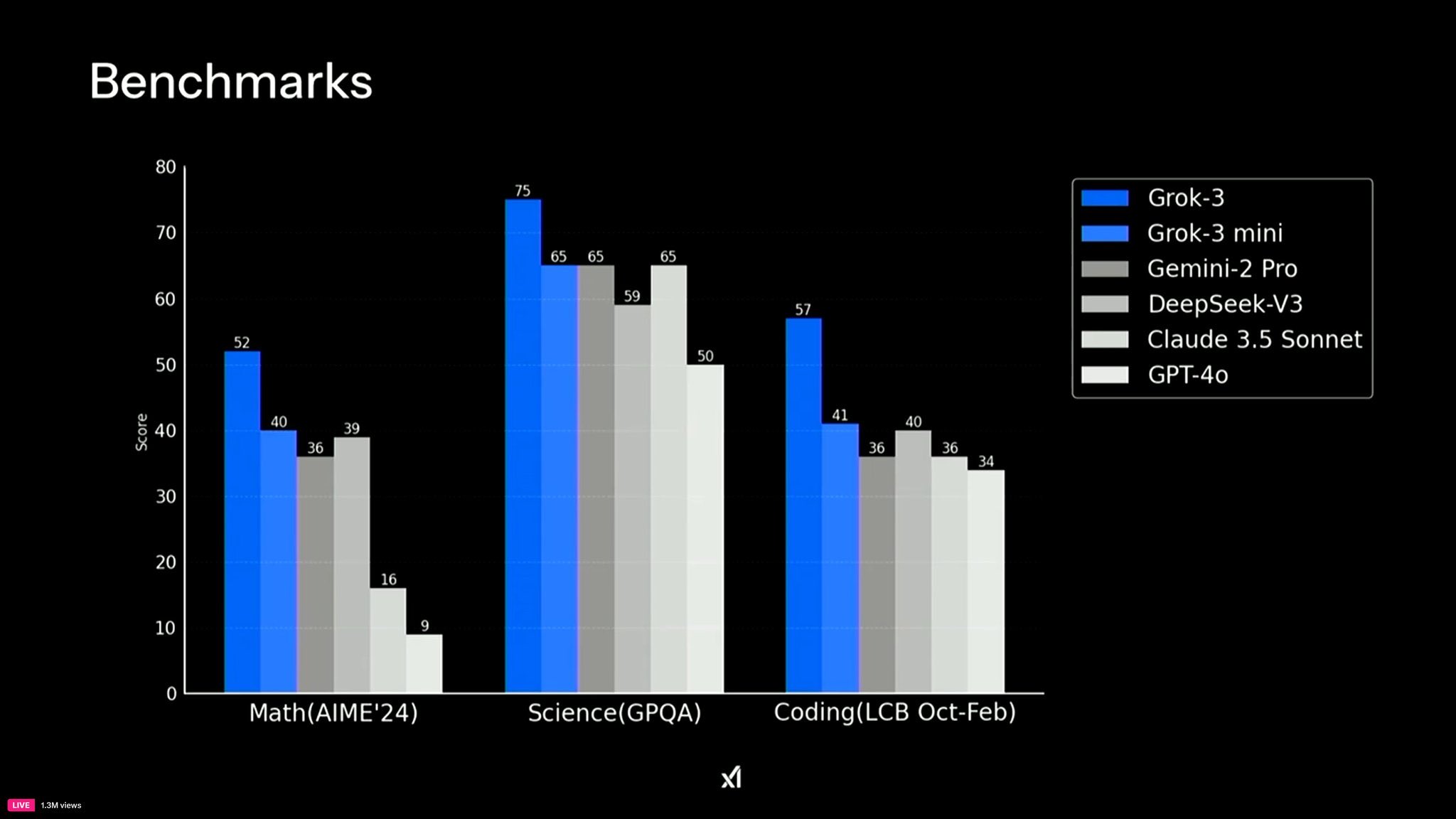

Grok向上,ChatGPT向下:你现在还在用ChatGPT吗?

Grok3用过了吗? 这两天,Grok 3的火爆程度,堪比春节期间的DeepSeek啊。 而,实际用过之后,你 […]

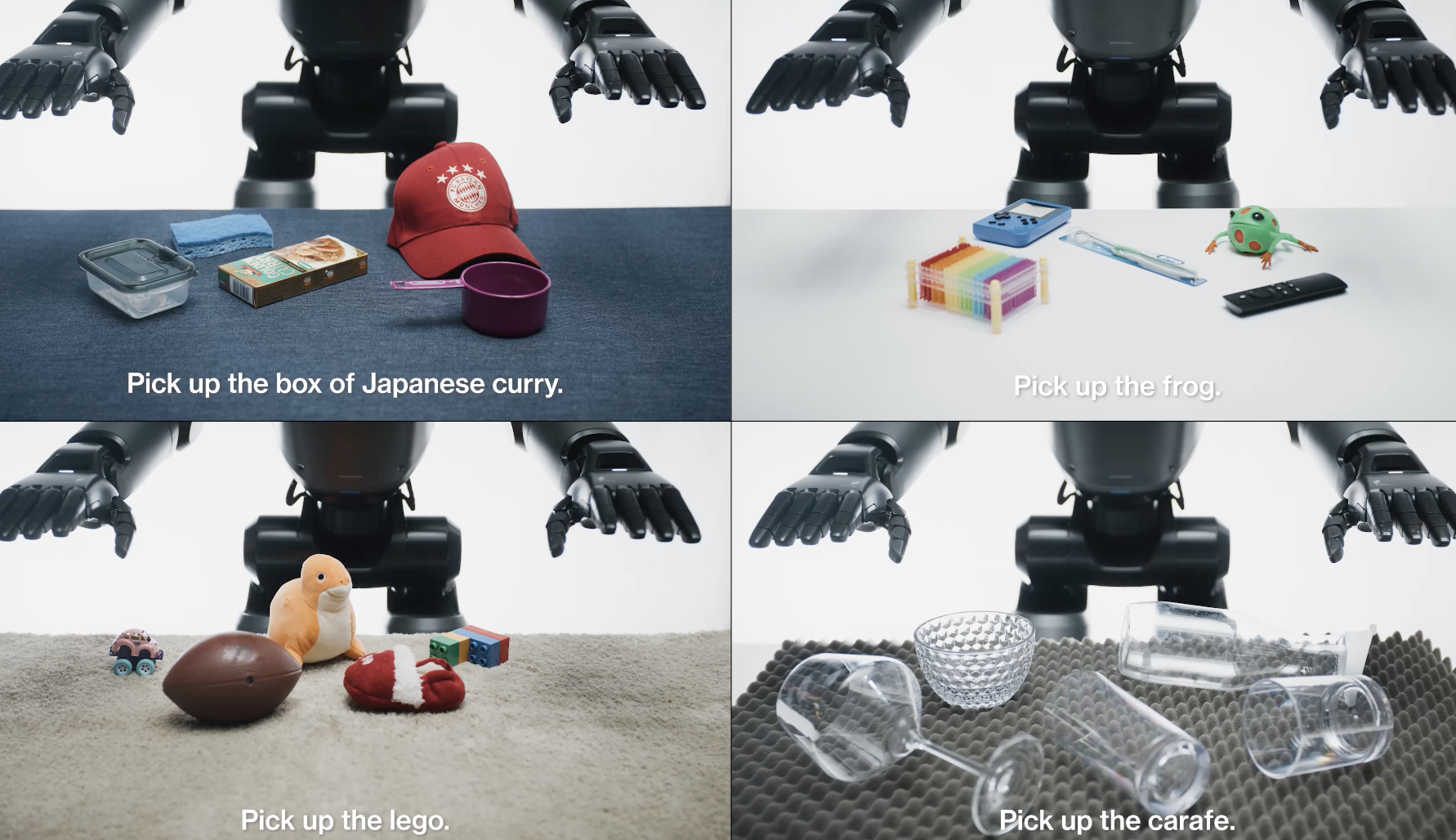

Helix:Figure发布了类人生物控制模型

两周前,Figure和OpenAI分手,号称要用自己的大模型。大家纷纷猜测,会不会是DeepSeek,但,我们 […]

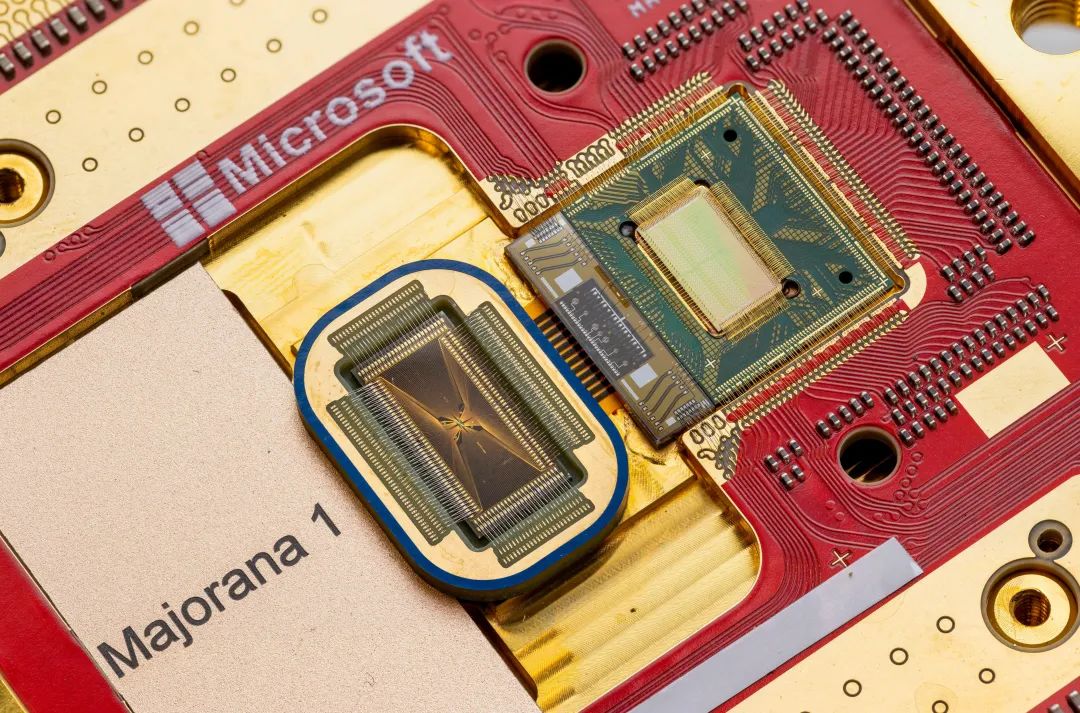

Majorana 1发布:微软的量子计算芯片

今天,微软发布了它的量子计算芯片——Majorana 1 。 不得不说,这是个划时代的产品,不亚于两年前Cha […]

Grok 3来了:20万张卡能否烧出一个全球最聪明AI?

Grok 3发布 20万张卡的数据中心,堪称大模型的“超级工厂”。而它,是专为Grok 3而建。 今天,马斯克 […]