AIGC

Vad är AIGC?

AIGC är förkortningen av engelska AI-genererat innehåll, vilket är artificiell intelligens-genererat innehåll.

Enkelt uttryckt använder den några snabba ord för att generera textinnehåll, bilder, videor, animationer och till och med kod.

Principen för AIGC

Principen för AIGC är faktiskt mycket enkel Med utvecklingen av artificiell intelligens fram till nu, har förmågan till "emergence" dykt upp AIGC:s "emergence"-förmåga för att tillåta artificiell intelligens att föreställa sig, resonera och analysera. och i slutändan "uppstår" innehåll.

Innebörden av AIGC

AIGC kommer att förändra hela innehållsindustrin.

AIGC har avsevärt förbättrat produktiviteten för textinnehåll, bildinnehåll, videoinnehåll och animationsinnehåll och förbättrat effektiviteten i produktionen av innehåll. Därför kommer i framtiden en stor mängd högkvalitativt innehåll att produceras eller assisteras i produktionen genom artificiell intelligens.

更多介绍,请查看AIGC页。

Kling AI: Kuaishous stora videogenereringsmodell är jämförbar med Sora

Kling AI är en stor videogenereringsmodell släppt av Kuaishou, som kan generera videor upp till 2 minuter långa. Dess främsta fördel är att använda Kuaishous egenutvecklade 3D-uttrycks- och kroppsrekonstruktionsteknik för att driva uttryck och kroppsrörelser genom ett helkroppsfoto av en karaktär. Kling AI är lämplig för att skapa scener som videor av karaktärer som sjunger och dansar och långa videor.

ChatTTS: Text-till-tal-modell för konversationsscenarier

Översikt Nyligen har en text-till-tal-modell blivit ganska populär: ChatTTS. Dessutom utvecklades denna modell av ett litet team i Kina. fokusera på[…]

GPT-4o: Gratis stora modeller med blandad ingång och blandad utgång

Släppningen av GPT-4o markerar en ny milstolpe inom hybrid input-output stora modeller, med rikare och snabbare konversationer. Dess fria användning och reducerade API-avgifter gör denna teknik tillgänglig för fler människor. Jämfört med Gemini1.5 Pro är GPT-4o överlägsen i konversationsupplevelse, och främjar utvecklingen av robotar och AIGC-applikationer. Detta framsteg representerar en viktig utveckling inom området generativ AI, vilket ger nya möjligheter till områden som interaktion mellan människa och dator och generering av innehåll.

Viggle AI: Hur man genererar videor med kontrollerbara karaktärsrörelser

Videogenereringsmodeller som Sora och Stable Video Dissfusion står ofta inför problemet med att inte kunna kontrollera utmatningsvideon exakt, särskilt på karaktärsrörelser. Den kontrollerbara videomodellen kan noggrant kontrollera karaktärernas handlingar i videon genom snabba ord. Viggle AI, som den första video-3D-modellen med faktiska fysiska förståelsemöjligheter, kan fritt styra karaktärsrörelser och är inbäddad i Discord-plattformen. Denna kontrollerbara videoteknik kommer att avsevärt minska kostnaderna för digitala mänskliga produkter och möjliggöra diversifierad digital mänsklig videoskapande.

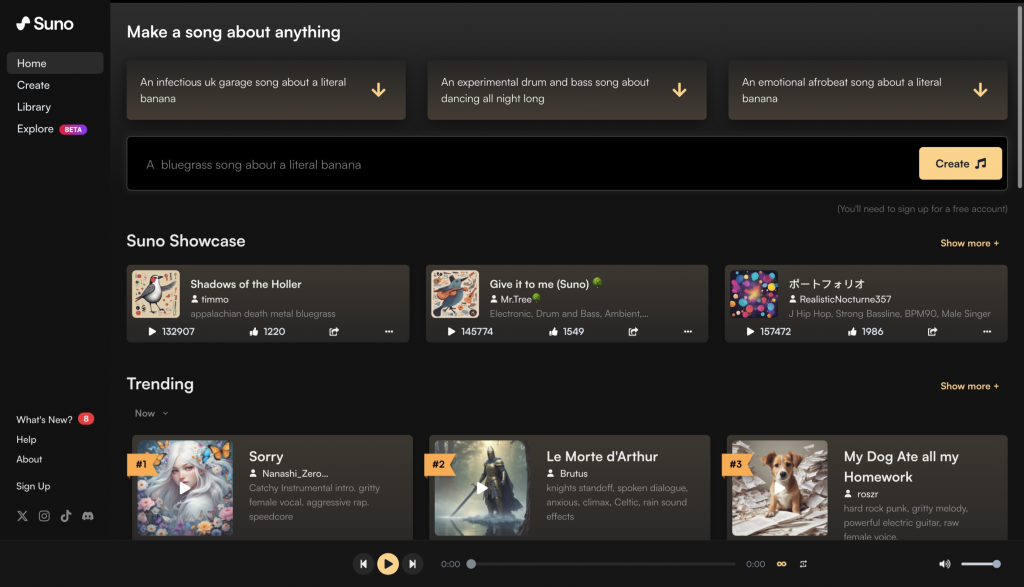

Suno AI: Hur man använder Suno AI för att göra en AI Music Generator

Suno AI, en storskalig modell som kan generera musik och låtar från uppmanade ord, har blivit ganska populär nyligen. Även om det inte finns något officiellt API-stöd, kan dess funktionalitet utnyttjas genom inofficiella gränssnitt. Användare behöver bara fylla i musiktypen och klicka på "Skapa" för att generera musik, vilket återspeglar de breda utsikterna och bekvämligheten med AI-musikgenerering.

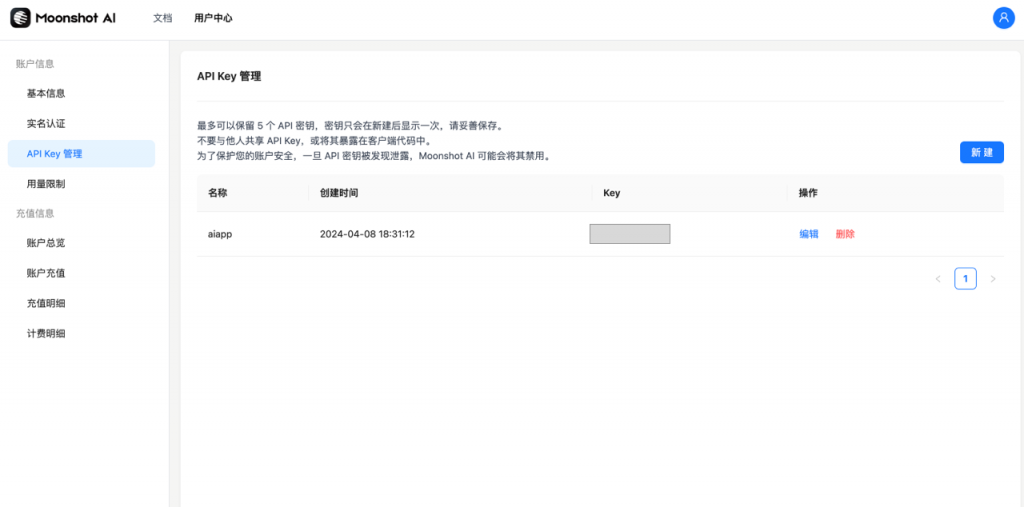

Moonshot AI: Hur får man tillgång till Kimi stora modell?

Kimi-modellen har väckt uppmärksamhet inom det inhemska AIGC-området och har integrerats i AI-SEO CN-versionen av WordPress-plugin. Den har utvecklats av Dark Side of the Moon Technology Company och har lång textinmatning och utmatning, upp till 2 miljoner ord. Användare arbetar på plattformen genom registrering och API-nycklar, och kan välja olika kontextlängdsmodeller. Priserna varierar beroende på modell och användarnivå, och integrationen är enkel och fungerar bra.

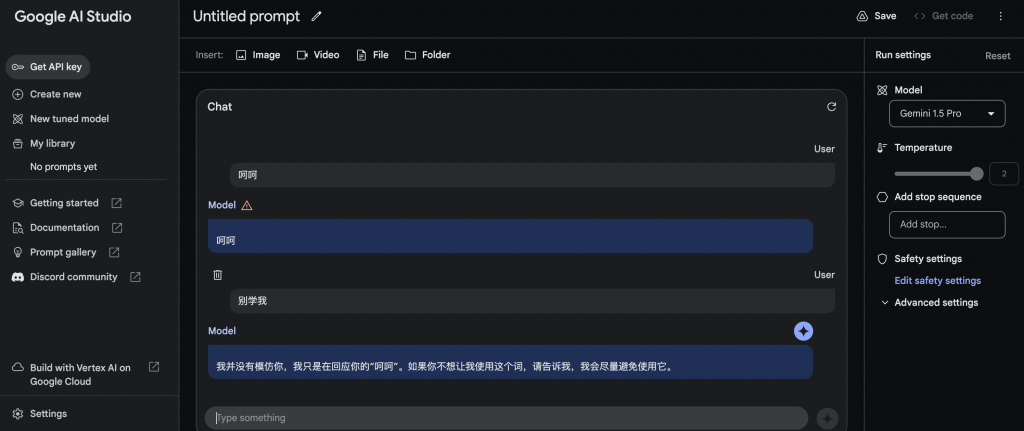

Google Gemini 1.5 Pro personligt test: kraftfullt och ömtåligt på samma gång

Efter att ha testat den nyligen uppgraderade multimodala AI-modellen Gemini 1.5 Pro, fann användarna att även om den stöder en mer omfattande inmatningstyp inklusive text, bilder, videor, filer och mappar, har resonemangsförmågan inte förbättrats avsevärt, särskilt när det gäller att skilja rätt från fel. Dessutom tar bearbetning av video-, fil- och mappindata lång tid, och det finns begränsningar i att hantera stora mängder data.

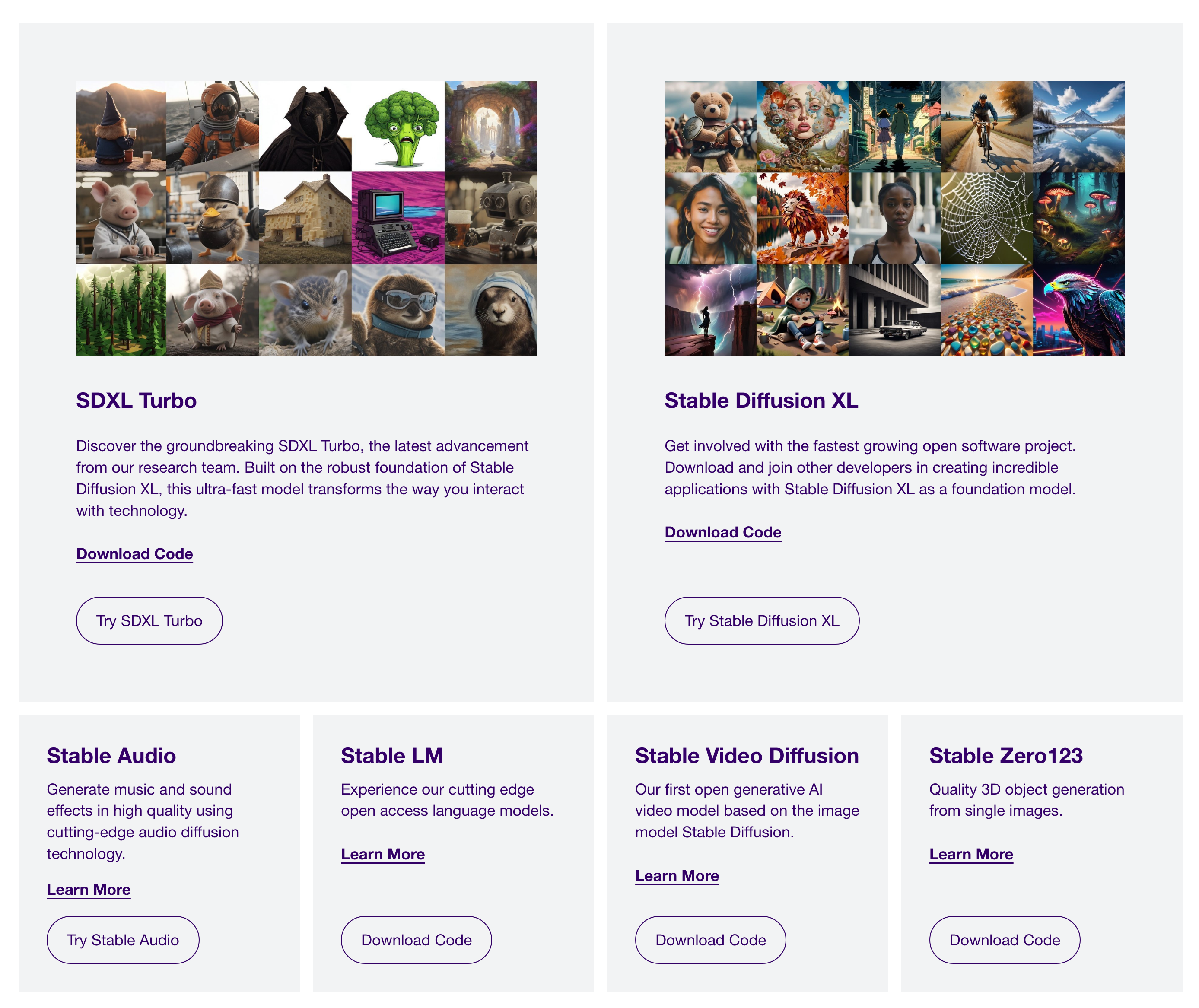

SDXL: Hur man använder stabil diffusion

Nyligen utvecklades ett WordPress-plugin baserat på den senaste versionen av Stable Diffusion XL (SDXL). Stable Diffusion är en gratis bildgenereringsmodell med öppen källkod, och koden kan laddas ner direkt via den officiella webbplatsen Stability AI. Även om det är dyrare och svårare att distribuera modellen själv, är det möjligt att använda en Docker-avbildning eller installera den manuellt. Dessutom kan stora modeller och API:er konsumeras eller distribueras via webbplatsen Replicate.com. I allmänhet används Stable Diffusion och SDXL i stor utsträckning i AI-bildgenereringsprodukter.

Heta ämnen i februari 2024: Sora - Open AI:s stora videogenereringsmodell

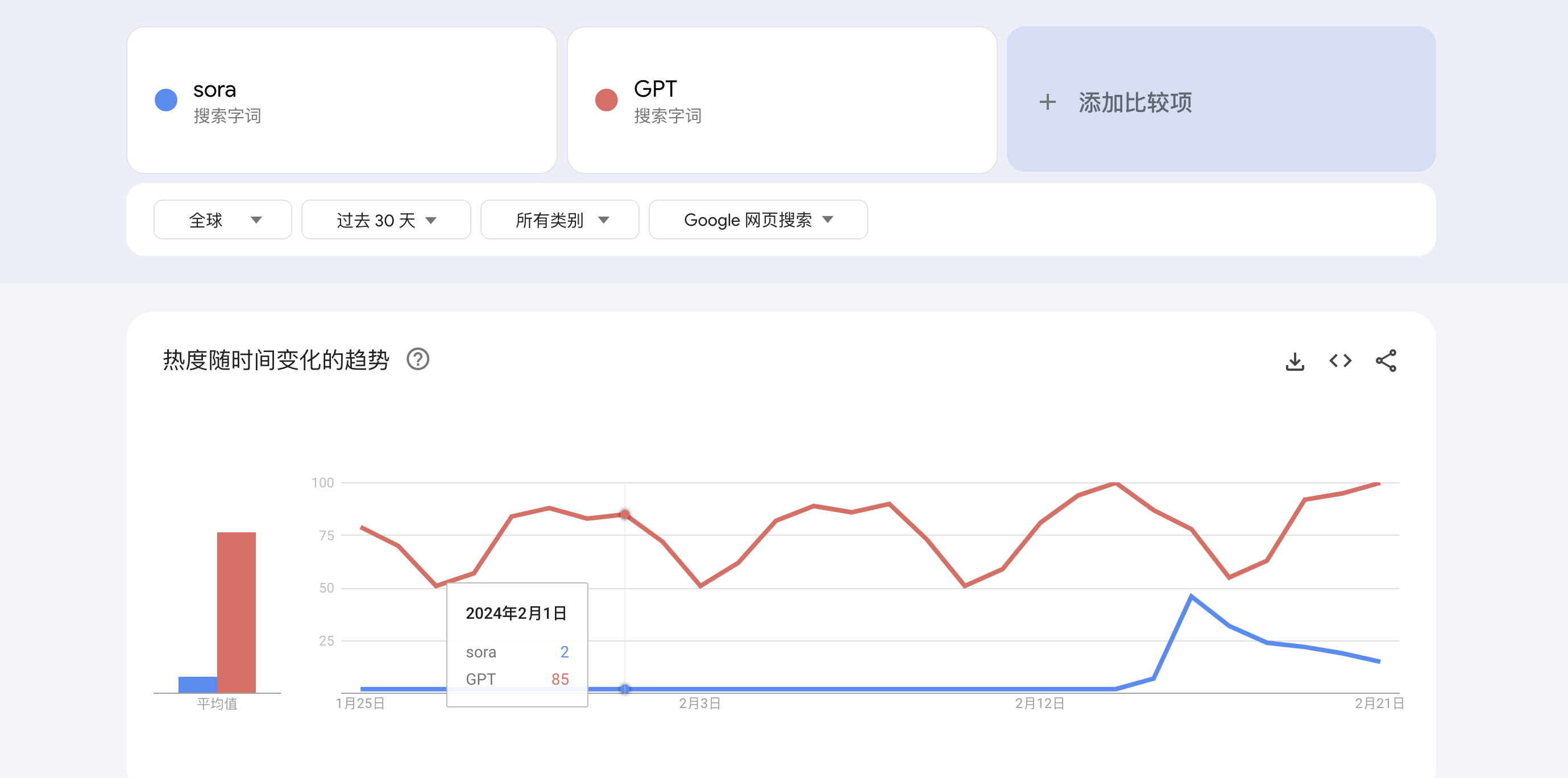

Den 16 februari 2024 släppte Open AI sin avancerade videogenerationsmodell med namnet Sora, vilket väckte intresse som nästan konkurrerade med GPT, som ännu inte är tillgänglig för allmänheten, och kombinerar transformator- och diffusionsarkitekturer för högfientlig videosimulering TikTok visar upp Soras möjligheter med oredigerade videor från olika uppmaningar, och förhandsgranskar dess potentiella inverkan på det växande videogenereringsfältet.

Hur man ansöker om att använda Baidu Wenxin stor modell?

Mitt AI SEO WordPress-plugin släppte en CN-version idag. AI SEO CN WordPress Plugin Prenumeration […]