筆記

WordPress AI SEO Pro v2.0 發布:合併海外版和國內版,支援多個大語言模型

原本的Wordpress AI SEO外掛程式分為了海外版和國內版,從這個版本開始,將海外版和國內版合併,合併之後[…]

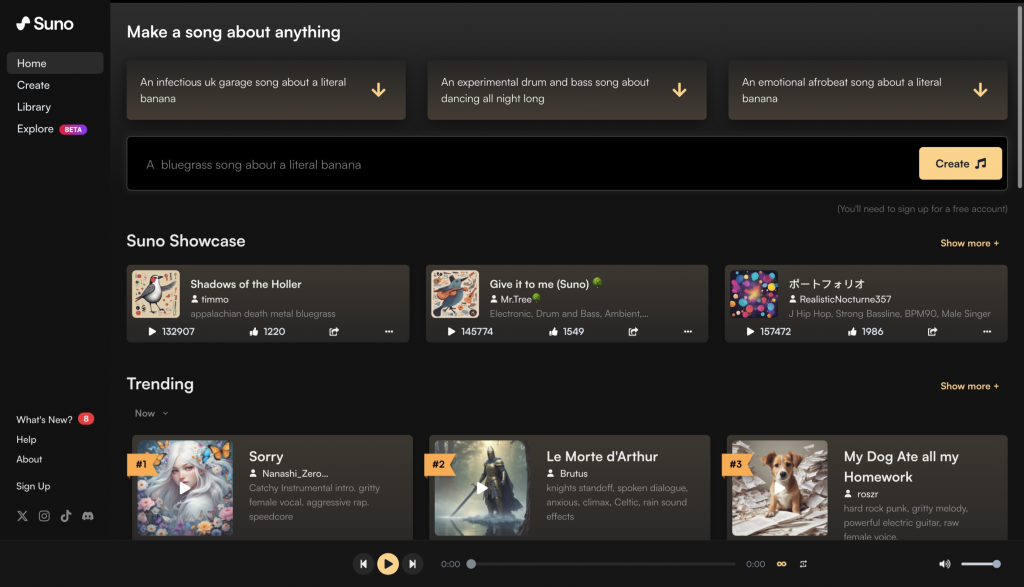

Suno AI: 如何用Suno AI做一個AI Music Generator

Suno AI,一款能透過提示詞產生音樂和歌曲的大型模型,近期頗受歡迎。儘管沒有官方API支持,但透過非官方介面也可利用其功能。用戶只需填入音樂類型和點擊「Create」即可生成音樂,體現了AI音樂生成的廣闊前景和便利性。

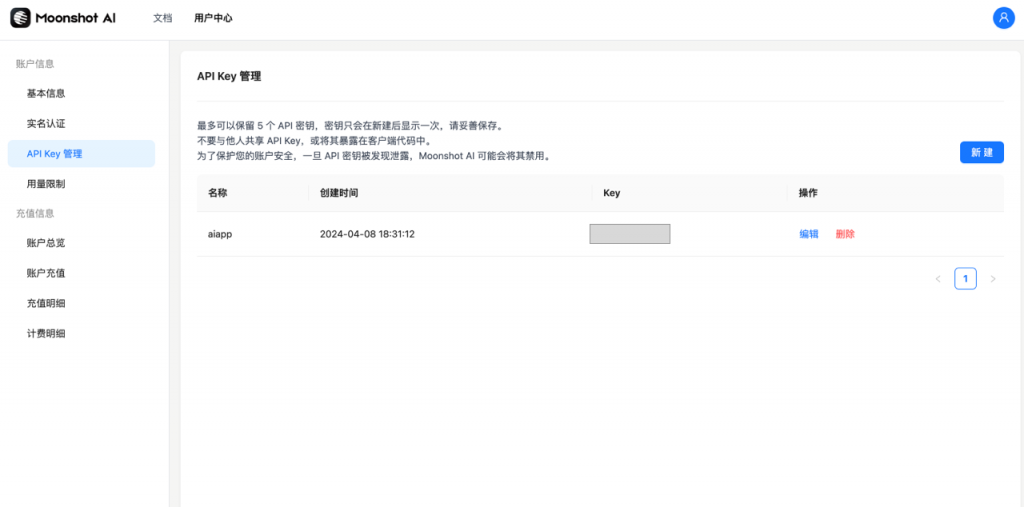

Moonshot AI: 如何連接Kimi大模型?

Kimi模型引起國內AIGC領域關注,已整合至AI SEO CN版Wordpress插件。由月之暗面科技公司開發,特點是長文本輸入與輸出,最高可達200萬字。使用者透過註冊和API金鑰在平台操作,並可選擇不同上下文長度模型。價格根據模型和用戶等級變化,整合應用簡易且性能良好。

百度文心大模型版本比較測試:ERNIE 3.5 8K VS ERNIE 4.0 8K

The AI SEO Wordpress Plugin is being upgraded to support Baidu's ERNIE 4.0 8K, although tests show little difference in SEO effectiveness compared to ERNIE 3.5 8K. Despite better stylistic quality with 4.0, the newer model is significantly more expensive and slower, with higher error rates during batch processing. Thus, ERNIE 3.5 8K remains the more cost-effective choice for SEO purposes.

AI SEO WordPress Plugin v1.2發布

春節前後, Google調整了其對AI生成內容的態度,導致大量用AI生成摘要的網站被K。但Google實際反對的是大量重複內容。 SEOer應製作對使用者有用且有差異的內容,理解搜尋意圖並創造內容。 AI SEO Wordpress外掛新增功能可協助依照大綱產生有用且獨特的內容。

robots.txt: 一個一直被忽略的SEO問題

After constructing two sites with Next.js last month and noticing poor Google indexation, the issue was identified as a missing robots.txt file. To address this, a robots.txt with rules to allow all user-agents, enablecontent access to allow all user-agents, enable access to allow excluding the 'private' directory, and link a sitemap was added to the Next.js app directory. This resolved the indexing issue, underscoring the importance of robots.txt for site visibility.

WordPress SEO:如何動態修改meta title?

meta title,也就是頁面的head標籤中的title標籤的內容,對於SEO是很重要的。有時候,我們需要[…]

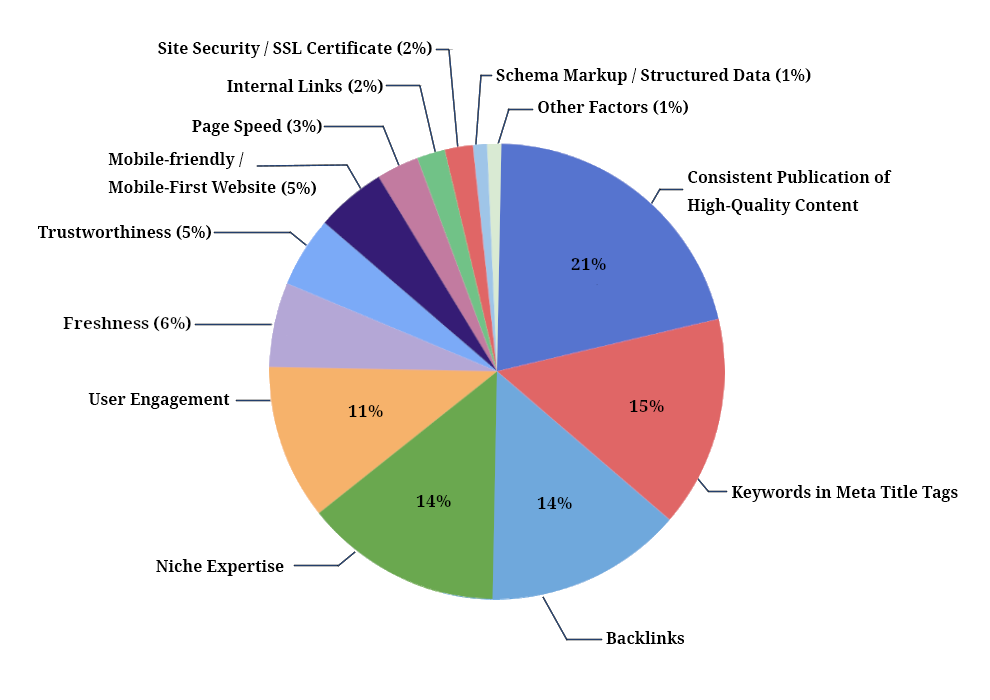

2024 SEO 趨勢:AI時代的SEO怎麼做?

一、2024年Google SEO排名要素佔比圖原文:https://firstpagesage.com/s […]

Google Gemini API開發指南:如何將Google Gemini整合到你的網站和專案中?

上個月,Google發布了Gemini。緊跟在後,我基於Google Gemini開發了AI SEO——自動和[…]

如何解決連接gethub的問題:Failed to connect to github.com port 443

問題最近幾天一直有這個問題: Failed to connect to github.com port 44 […]