IA

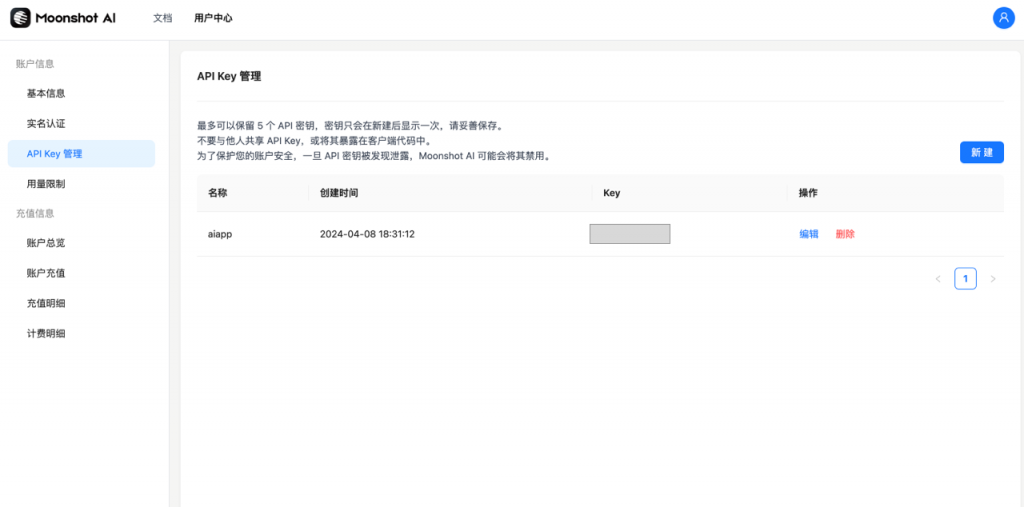

Moonshot AI : Comment accéder au grand modèle Kimi ?

Le modèle Kimi a attiré l'attention dans le domaine national de l'AIGC et a été intégré dans la version AI SEO CN du plug-in WordPress. Développé par Dark Side of the Moon Technology Company, il permet la saisie et la sortie de textes longs, jusqu'à 2 millions de mots. Les utilisateurs opèrent sur la plateforme via l'enregistrement et les clés API, et peuvent choisir différents modèles de longueur de contexte. Les prix varient en fonction du modèle et du niveau d'utilisateur, et l'intégration est simple et fonctionne bien.

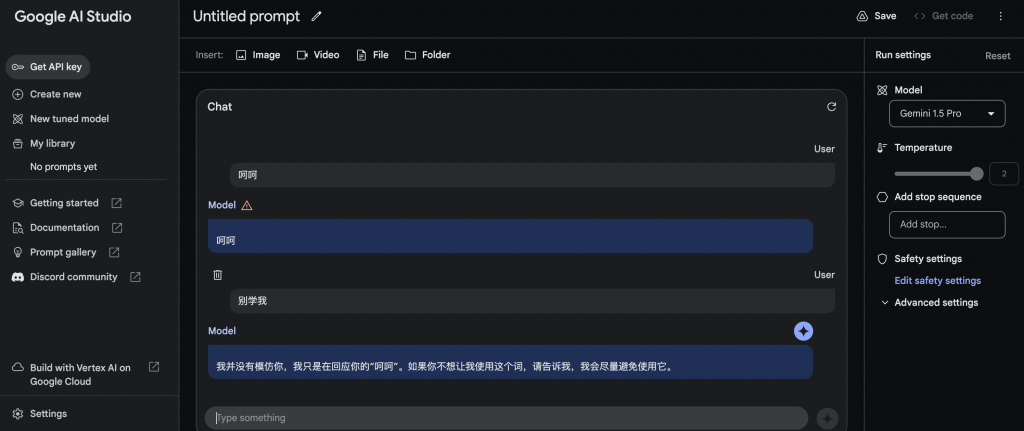

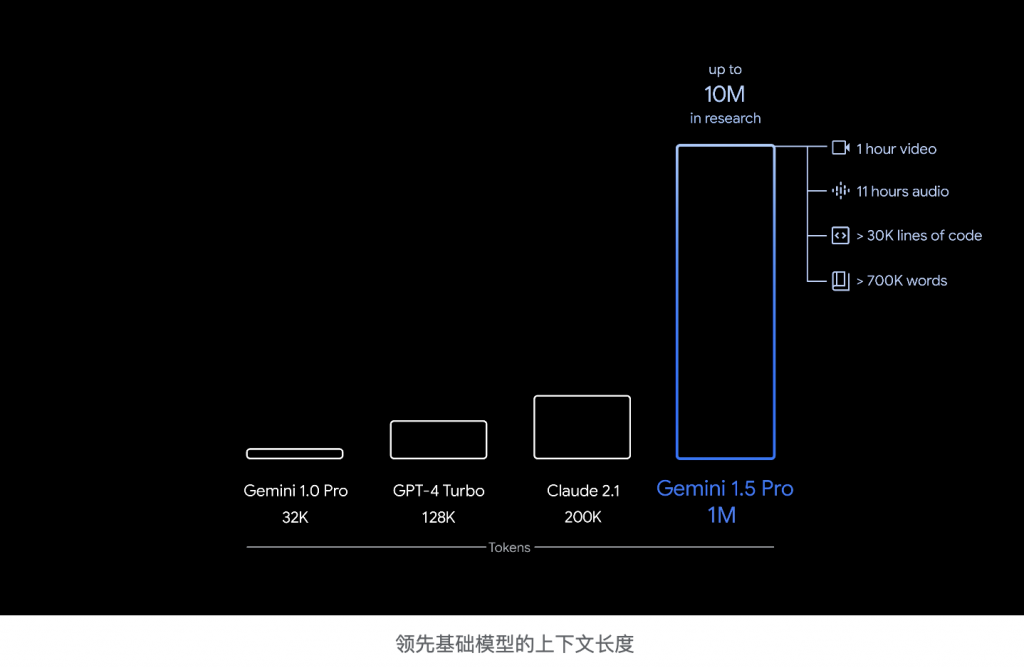

Test personnel Google Gemini 1.5 Pro : puissant et fragile à la fois

Après avoir testé le modèle d'IA multimodal Gemini 1.5 Pro récemment mis à niveau, les utilisateurs ont constaté que bien qu'il prenne en charge un type de saisie plus complet comprenant du texte, des images, des vidéos, des fichiers et des dossiers, la capacité de raisonnement n'a pas été significativement améliorée, en particulier pour distinguer le droit de faux. De plus, le traitement des entrées vidéo, fichiers et dossiers prend beaucoup de temps et il existe des limites dans la gestion de grandes quantités de données.

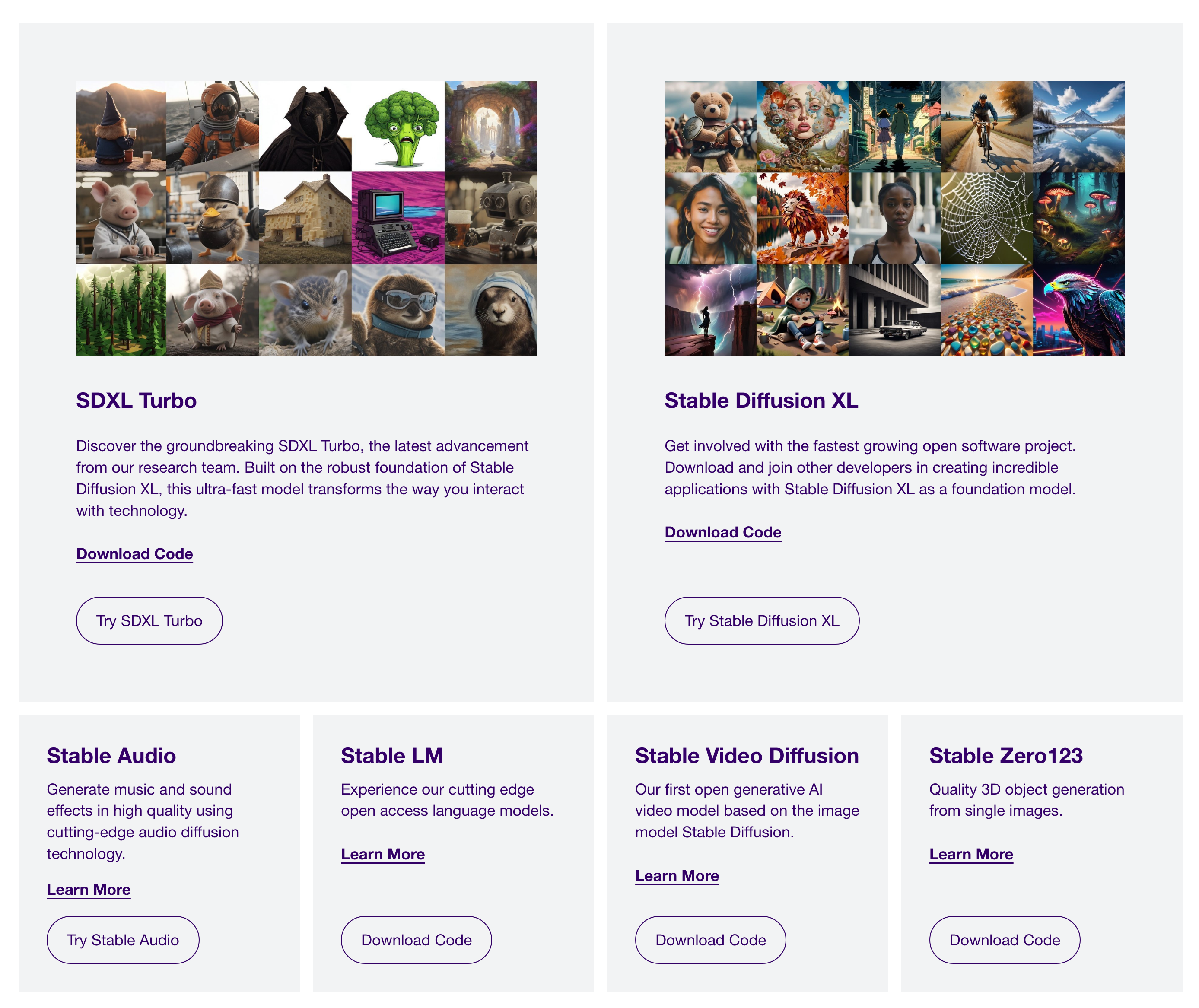

SDXL : Comment utiliser la diffusion stable

Récemment, un plugin WordPress basé sur la dernière version de Stable Diffusion XL (SDXL) a été développé. Stable Diffusion est un modèle de génération d'images gratuit et open source, et le code peut être téléchargé directement via le site officiel Stability AI. Bien qu’il soit plus coûteux et plus difficile de déployer le modèle soi-même, il est possible d’utiliser une image Docker ou de l’installer manuellement. De plus, de grands modèles et API peuvent être consommés ou déployés via le site Web Replicate.com. En général, Stable Diffusion et SDXL sont largement utilisés dans les produits de génération d’images IA.

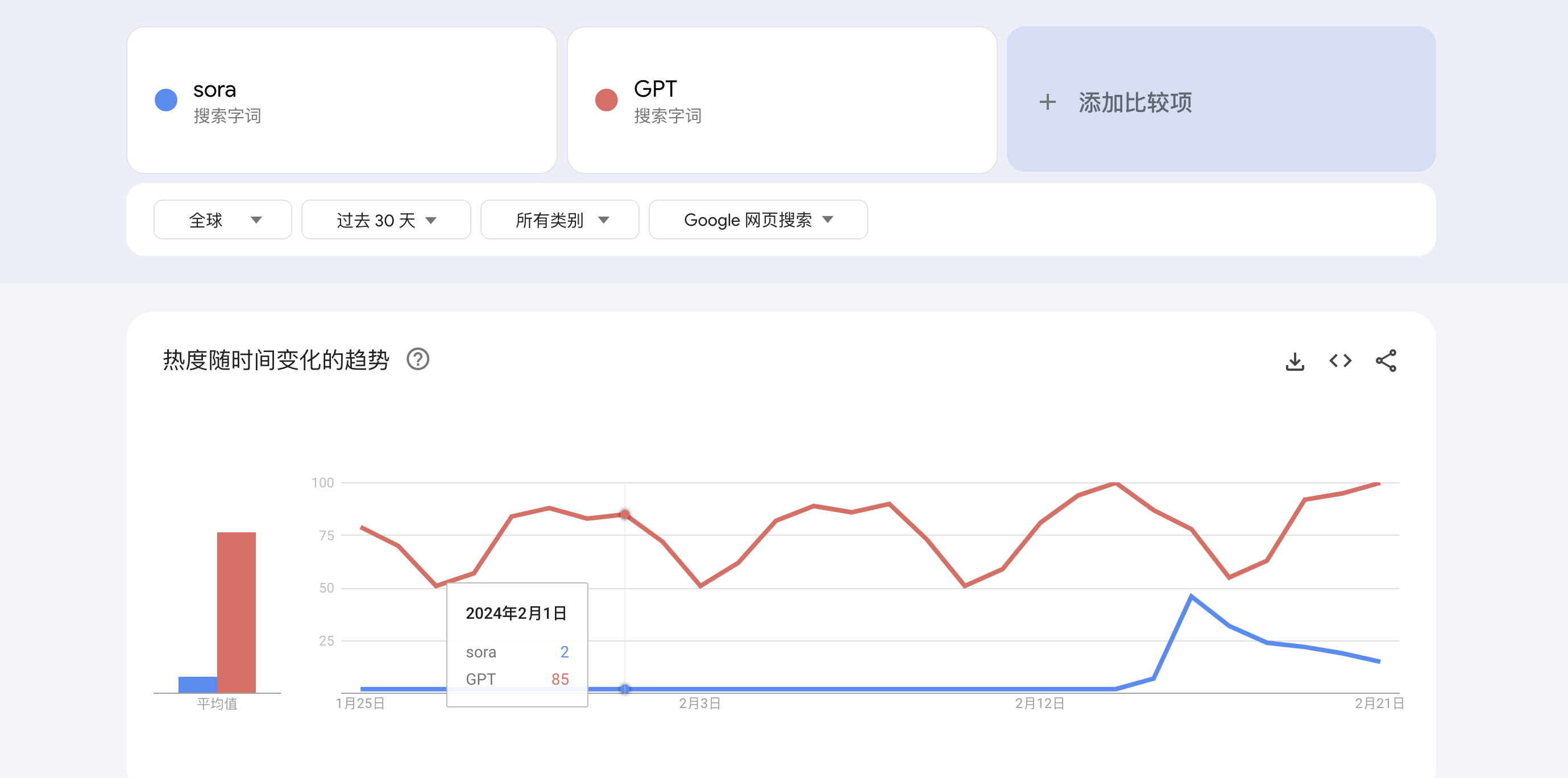

Sujets d'actualité en février 2024 : Sora - Le grand modèle de génération de vidéos d'Open AI

Le 16 février 2024, Open AI a publié son modèle avancé de génération vidéo nommé Sora, suscitant un intérêt rivalisant presque avec celui de GPT. Sora, qui n'est pas encore disponible pour un usage public, combine des architectures de transformateur et de diffusion pour une simulation vidéo haute fidélité. TikTok présente les capacités de Sora avec des vidéos non éditées à partir de diverses invites, donnant un aperçu de son impact potentiel dans le domaine en plein essor de la génération vidéo.

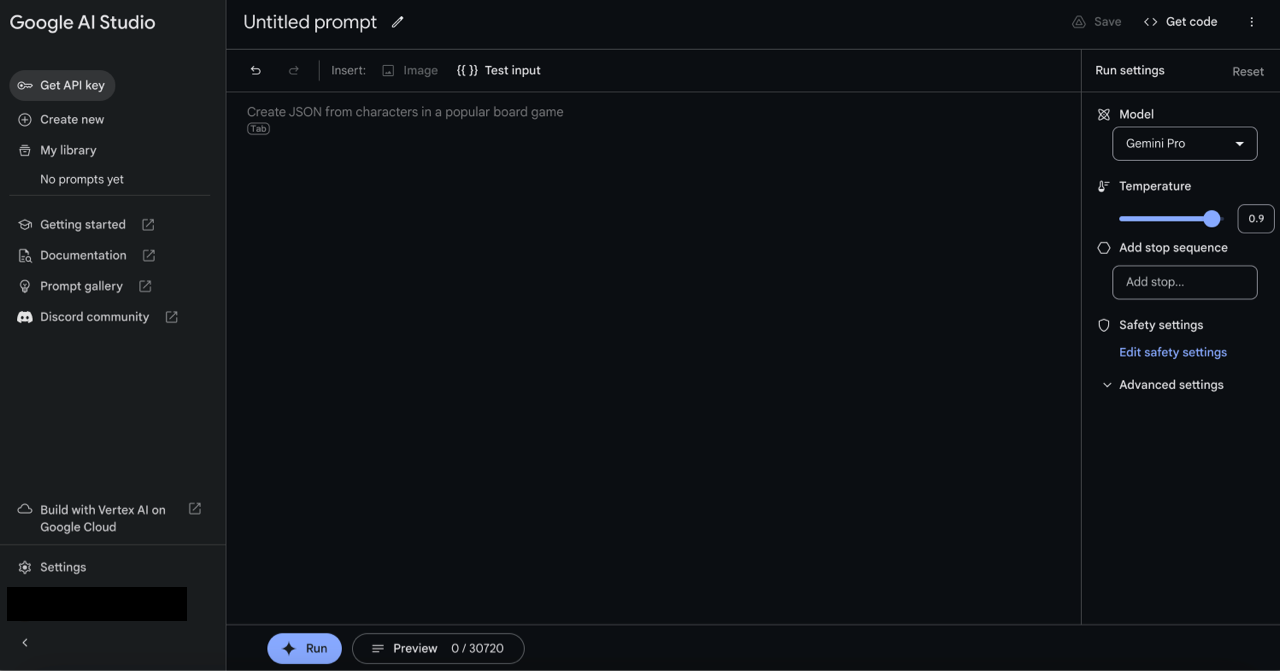

Gemini 1.5 pro : Comment postuler

Présentation de Google Gemini1.5 pro Google Gemini1.5 pro le 15 février 2024 […]

Comment postuler pour utiliser le grand modèle Baidu Wenxin ?

Mon plugin WordPress AI SEO a publié une version CN aujourd'hui. Abonnement au plugin WordPress AI SEO CN […]

Google Gemini : Comment utiliser le grand modèle linguistique de Google Gemini

Le grand modèle de langage multimodal de Google a été récemment publié. Site officiel de Google Gemini Google Gemini est divisé en trois versions […]

Qu'est-ce que l'AIGC : Comprendre l'AIGC en un seul article

AIGC fait référence au contenu généré par l'IA, qui implique que l'intelligence artificielle génère du texte, des images, des vidéos, etc. Créé en 2022, le grand modèle de langage constitue sa base, interagissant avec les agents d'IA via des mots d'invite, le contexte et l'IA. L'AIGC a commencé à changer l'industrie du contenu et à accélérer l'efficacité de la production. Il est actuellement utilisé dans de nombreuses directions, telles que les robots de discussion et la génération de contenu, et a donné naissance à un écosystème industriel centré sur les capacités de grands modèles.

La direction de l’IA générative : une percée dans le domaine des robots

L’IA est une grande opportunité. Par conséquent, tout le monde explore, s’il sait quoi faire ou ce qu’il ne sait pas faire. À l'heure actuelle, la direction de l'exploration se situe principalement dans […]

AIGC : intégrez le grand modèle Wenxin Qianfan de Baidu dans WordPress et comparez-le avec GPT

# intègre le grand modèle Wenxin Qianfan de Baidu dans WordPress et le compare avec GPT

Le week-end dernier, le modèle Wenxin Qianfan de Baidu a été intégré à WordPress.

1. Processus de base :

1. Postulez d’abord pour découvrir le grand modèle Wenxin Qianfan sur Baidu, qui nécessite d’abord une certification.

2. Après avoir réussi, activez le grand modèle, car le grand modèle de Baidu est facturé à l'utilisation et facturé par jeton. Vous devez avoir un solde sur votre compte pour l'activer.

3. Ensuite, créez une application pour qu'elle ait un appid, une clé API et une clé secrète

4. Ensuite, lisez la documentation et connectez l'interface correspondante.

Fondamentalement, vous obtenez le jeton d'accès via la clé API et la clé secrète, puis soumettez la question et obtenez la réponse.

2. Code clé

1. Obtenez le code clé du jeton d'accès

"`php

fonction privée getAccessToken(){

$curl = curl_init();

curl_setopt_array($curl, tableau(

CURLOPT_URL => "https://aip.baidubce.com/oauth/2.0/token?client_id=".$this->client_id."&client_secret=".$this->client_secret."&grant_type=client_credentials",

CURLOPT_TIMEOUT => 30,

CURLOPT_RETURNTRANSFER => vrai,

CURLOPT_CUSTOMREQUEST => 'POST',

CURLOPT_HTTPEADER => tableau(

'Type de contenu : application/json',

'Accepter : application/json'

),

));

$response = curl_exec($curl);

curl_close($curl);

$rtn = json_decode($response);

renvoie $rtn->access_token ;

}

“`

2. Appelez le code clé du grand modèle Ernie Bot

"`php

fonction publique runErnieBot($message) {

$curl = curl_init();

curl_setopt_array($curl, tableau(

CURLOPT_URL => "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/completions?access_token={$this->getAccessToken()}",

CURLOPT_TIMEOUT => 30,

CURLOPT_RETURNTRANSFER => vrai,

CURLOPT_CUSTOMREQUEST => 'POST',

CURLOPT_POSTFIELDS =>$message,

CURLOPT_HTTPEADER => tableau(

'Type de contenu : application/json'

),

));

$response = curl_exec($curl);

curl_close($curl);

renvoie $response ;

}

“`

3. Appelez le code clé du grand modèle Ernie Bot Turbo

"`php

fonction publique runErnieBotTurbo($message) {

$curl = curl_init();

curl_setopt_array($curl, tableau(

CURLOPT_URL => "https://aip.baidubce.com/rpc/2.0/ai_custom/v1/wenxinworkshop/chat/eb-instant?access_token={$this->getAccessToken()}",

CURLOPT_TIMEOUT => 30,

CURLOPT_RETURNTRANSFER => vrai,

CURLOPT_CUSTOMREQUEST => 'POST',

CURLOPT_POSTFIELDS =>$message,

CURLOPT_HTTPEADER => tableau(

'Type de contenu : application/json'

),

));

$response = curl_exec($curl);

curl_close($curl);

renvoie $response ;

}

“`

Au cours des derniers jours de tests, les performances du grand modèle de Baidu Wenxin Qianfan en chinois sont en effet bien meilleures que celles de GPT.

Le niveau chinois du GPT est le niveau du « texte explicatif ».

Le niveau chinois du Baidu Wenxin Qianfan Large Model est au moins meilleur que le « texte explicatif ».